- DALL-E 2 мечты в картинках

- Инженер Google считает LaMDA разумным

- DeepMind AlphaFold предсказывает почти все известные структуры белков

- Stable Diffusion обеспечивает синтез изображений с открытым исходным кодом

- AI арт ИИ победило в конкурсе на государственной ярмарке, художники реагируют

- CICERO от Meta осваивает дипломатию

- ChatGPT разговаривает с миром

Основные моменты года, когда искусственный интеллект (ИИ) стал мейнстримом.

В этом году эксперты по искусственному интеллекту не раз повторяли знакомый фрагмент: “Пожалуйста, помедленнее”. Новости ИИ в 2022 году были стремительными и неумолимыми. Как только вы узнавали, на каком этапе развития находится ИИ, новая статья или открытие тут же делали это мнение устаревшим.

В 2022 году мы, пожалуй, достигли предела в развитии ИИ, который может создавать творческие произведения из текста, изображений, аудио и видео. В этом году ИИ с глубоким обучением вышел из десятилетнего периода исследований и начал применяться в коммерческих приложениях, что позволило миллионам людей впервые опробовать эту технологию. Создания ИИ вызывали удивление, вызывали споры, приводили к экзистенциальным кризисам и вскружили голову.

Предлагаем вашему вниманию семь самых громких новостей года, связанных с ИИ. Было трудно выбрать только семь, но если бы мы не прервали их, мы бы продолжали писать о событиях этого года до 2023 года и далее.

DALL-E 2 мечты в картинках

В апреле OpenAI анонсировал DALL-E 2, модель синтеза изображений с глубоким обучением, которая поразила умы своей, казалось бы, волшебной способностью генерировать изображения по текстовым подсказкам. Обученный на сотнях миллионов изображений, взятых из Интернета, DALL-E 2 знал, как создавать новые комбинации образов благодаря технике, называемой скрытой диффузией.

Вскоре Twitter наполнился изображениями астронавтов на лошадях, плюшевых медведей, бродящих по Древнему Египту, и другими почти фотореалистичными работами. В последний раз мы слышали о DALL-E за год до этого, когда первая версия модели с трудом отображала стул из авокадо с низким разрешением, и вдруг вторая версия стала иллюстрировать наши самые смелые мечты в разрешении 1024×1024.

Сначала, учитывая опасения по поводу злоупотреблений, OpenAI разрешил использовать DALL-E 2 только 200 бета-тестерам. Контент-фильтры блокировали подсказки насильственного и сексуального характера. Постепенно OpenAI допустила к закрытому тестированию более миллиона человек, и в конце сентября DALL-E 2 наконец стал доступен для всех. Но к тому времени в мире латентной диффузии появился еще один претендент, о чем мы расскажем ниже.

Инженер Google считает LaMDA разумным

В начале июля газета Washington Post сообщила, что инженер Google по имени Блейк Лемуан был отправлен в оплачиваемый отпуск в связи с его убеждением, что языковая модель Google LaMDA (Language Model for Dialogue Applications) является разумной и что она заслуживает прав, равных человеческим.

Работая в составе организации Google Responsible AI, Лемуан начал общаться с LaMDA о религии и философии и поверил, что видит за текстом настоящий интеллект. “Я узнаю человека, когда разговариваю с ним”, – сказал Лемуан в интервью газете Post. “Неважно, есть ли у них в голове мозг, сделанный из мяса. Или у них миллиард строк кода. Я разговариваю с ними. И я слышу, что они говорят, и именно так я решаю, что есть человек, а что нет”.

Google ответил, что LaMDA говорит Лемуану только то, что он хочет услышать, и что LaMDA на самом деле не является разумной. Как и инструмент генерации текста GPT-3, LaMDA ранее был обучен на миллионах книг и веб-сайтов. Она реагировала на ввод Лемуана (подсказка, включающая весь текст разговора), предсказывая наиболее вероятные слова, которые должны последовать за этим, без какого-либо более глубокого понимания.

Попутно Лемуан якобы нарушил политику конфиденциальности Google, рассказав другим о работе своей группы. Позже, в июле, Google уволил Лемуана за нарушение политики безопасности данных. Как мы увидим, он был не последним человеком в 2022 году, который увлекся шумихой вокруг большой языковой модели ИИ.

DeepMind AlphaFold предсказывает почти все известные структуры белков

В июле компания DeepMind объявила, что ее модель ИИ AlphaFold предсказала форму почти всех известных белков почти всех организмов на Земле с секвенированным геномом. Первоначально объявленная летом 2021 года, AlphaFold ранее предсказала форму всех человеческих белков. Но уже через год его база данных белков расширилась и стала содержать более 200 миллионов белковых структур.

DeepMind разместил эти предсказанные структуры белков в общедоступной базе данных Европейского института биоинформатики при Европейской лаборатории молекулярной биологии (EMBL-EBI), что позволило исследователям со всего мира получить к ним доступ и использовать данные для исследований в области медицины и биологии.

Белки являются основными строительными блоками жизни, и знание их формы может помочь ученым контролировать или изменять их. Это особенно полезно при разработке новых лекарств. “Почти каждое лекарство, появившееся на рынке за последние несколько лет, было разработано частично на основе знаний о структуре белков, – говорит Джанет Торнтон, старший научный сотрудник и почетный директор EMBL-EBI. Поэтому знание всех этих структур имеет большое значение”.

Stable Diffusion обеспечивает синтез изображений с открытым исходным кодом

22 августа компании Stability AI и CompVis выпустили Stable Diffusion 1.4, модель синтеза изображений, аналогичную DALL-E 2 от OpenAI. Но если DALL-E запускалась как закрытая модель со значительными ограничениями, то Stable Diffusion появилась в виде проекта с открытым исходным кодом и файлами контрольных точек. (Данные для обучения модели были обработаны в облаке на сумму 600 000 долларов США). Его открытость позволила неограниченно генерировать любой синтезированный контент. Кроме того, в отличие от DALL-E 2, люди могли использовать Stable Diffusion локально и конфиденциально на своих ПК с достаточно хорошим GPU.

Однако переход Stability AI не был повсеместно воспринят как триумф технологии. Критики жаловались на потенциал программного обеспечения для создания политической дезинформации, порнографии без согласия, материалов о сексуальном насилии над детьми и альтернативных историй. Художники жаловались, что программа может украсть стиль живых художников и лишить их работы. Предвзятость набора данных, используемого для обучения модели, также вызвала критику, а методы, использованные для создания набора изображений, оказались проблематичными, когда кто-то обнаружил, что ее частные медицинские фотографии были взяты из сети без права на удаление.

Между тем, некоторые любители полностью приняли Stable Diffusion и быстро создали вокруг него экосистему с открытым исходным кодом. Некоторые продукты интегрировали его движок в свои собственные сайты и приложения. Множество производных моделей ИИ, обученных на конкретных предметах, таких как искусство Диснея, обувь или порнография, появилось благодаря технике под названием Dreambooth, которая позволяет легко настраивать модель Stable Diffusion. Сейчас, когда вышла версия 2.1, Stable Diffusion продолжает занимать важное место в области синтеза изображений.

AI арт ИИ победило в конкурсе на государственной ярмарке, художники реагируют

В начале августа житель Колорадо по имени Джейсон Аллен представил три сгенерированных ИИ изображения на конкурс изобразительного искусства на ярмарке штата Колорадо. В конце месяца он объявил, что одна из работ, “Пространственный театр оперы”, получила главный приз в категории “Цифровое искусство/ цифровая манипулированная фотография”. Когда новость о победе распространилась, люди были вне себя от радости.

Для создания своих художественных работ Аллен использовал Midjourney, коммерческую модель синтеза изображений, похожую на Stable Diffusion (но с собственным отличительным художественным стилем), которая работает через собственный сервер Discord. Он напечатал три изображения на холсте и представил их на конкурс. Символическая победа искусственного интеллекта над человечеством вызвала ожесточенные дебаты в социальных сетях о природе искусства и о том, что значит быть художником.

В 2022 году развернулась большая культурная борьба по поводу этичности произведений искусства, созданных ИИ. Компьютерные ученые, стоящие за этим, рассматривают синтез изображений ИИ как неизбежный и позитивный технологический шаг, но художники, которые тренировались десятилетиями, видят в этом экзистенциальный риск. В социальных сетях звучали угрозы смерти, а сообщества художников жаловались или устраивали акции протеста против искусства ИИ. Эти споры продолжаются и сегодня, и, возможно, в ближайшее время они не будут разрешены.

CICERO от Meta осваивает дипломатию

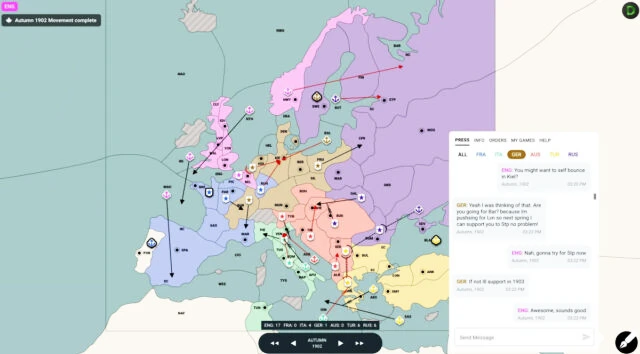

В конце ноября компания Meta анонсировала Cicero, агент ИИ, который может победить человека в настольной стратегической игре “Дипломатия” в онлайн-играх, проводимых на сайте webDiplomacy. Это большое достижение, потому что “Дипломатия” – это в значительной степени социальная игра, которая требует большого количества убеждений, сотрудничества и переговоров с другими игроками, чтобы победить. По сути, Мета разработала бота, который может обмануть человека, заставив его думать, что он играет с другим человеком.

Чтобы получить навыки ведения переговоров, Meta обучила большой компонент языковой модели Cicero на текстах, взятых из Интернета, а также на стенограммах 40 000 сыгранных людьми партий в дипломатию с сайта webDiplomacy. Между тем, Meta также разработала стратегический компонент, который может смотреть на состояние игры и предсказывать поведение других игроков, а затем действовать соответствующим образом.

Meta считает, что может применить уроки Цицерона для создания нового поколения видеоигр с более интеллектуальными NPC или для облегчения коммуникационных барьеров между людьми и ИИ во время многосеансовых бесед. Та же техника, примененная к другим социальным сценариям, может, конечно, манипулировать людьми или обманывать их, выдавая себя за людей.

ChatGPT разговаривает с миром

В последний день ноября OpenAI анонсировал ChatGPT, чат-бота, основанного на крупной языковой модели GPT-3. OpenAI сделала его доступным бесплатно через свой сайт, чтобы собрать данные и отзывы общественности о том, как доработать модель для получения более точных и менее потенциально опасных результатов.

Через пять дней после запуска генеральный директор OpenAI Сэм Альтман написал в Твиттере, что ChatGPT посетило более 1 миллиона пользователей. Люди использовали его для помощи в программировании, имитации сеанса работы с консолью Linux, составления рецептов, написания стихов и многого другого. Исследователи также быстро сообразили, как использовать атаки типа prompt injection для обхода ограничений, запрещающих инструменту отвечать на потенциально опасные вопросы.

Хотя ChatGPT использовал лучшее из того, что GPT-3 уже предоставлял с 2020 года (с некоторыми заметными улучшениями под капотом), бесплатный ценник означал, что это был первый раз, когда массовая аудитория увидела, на что способна технология GPT от OpenAI. Она манила своей очевидной способностью понимать сложные вопросы – если бы только она могла давать достоверно точные ответы. Эта часть, признает генеральный директор OpenAI, находится в стадии разработки. Но ворота уже открыты, и мы видим проблеск будущего, основанного на ИИ.